Langfuse 是什么? Langfuse 是一个开源的 LLM 工程平台,帮助团队追踪 API 调用、监控性能以及调试其 AI 应用程序中的问题。

追踪 LangChain

Langfuse Tracing 通过 LangChain 回调(Python, JS)与 LangChain 集成。因此,Langfuse SDK 会自动为您的 LangChain 应用程序的每次运行创建一个嵌套追踪。这使您能够记录、分析和调试您的 LangChain 应用程序。 您可以通过 (1) 构造函数参数或 (2) 环境变量来配置集成。在 cloud.langfuse.com 注册或自托管 Langfuse 获取您的 Langfuse 凭据。构造函数参数

环境变量

追踪 LangGraph

这一部分演示了 Langfuse 如何通过 LangChain 集成 帮助调试、分析和迭代您的 LangGraph 应用程序。初始化 Langfuse

注意:您需要运行至少 Python 3.11 版本(GitHub Issue)。 使用您在 Langfuse UI 项目设置中的 API 密钥 初始化 Langfuse 客户端,并将它们添加到您的环境中。使用 LangGraph 构建简单聊天应用

本节将要完成的内容- 在 LangGraph 中构建一个可以回答常见问题的支持聊天机器人

- 使用 Langfuse 追踪聊天机器人的输入和输出

创建 Agent

首先创建一个StateGraph。StateGraph 对象将我们的聊天机器人结构定义为一个状态机。我们将添加节点来表示 LLM 和聊天机器人可以调用的函数,以及边来指定机器人如何在这些函数之间转换。

将 Langfuse 添加为调用的回调

现在,我们将添加 LangChain 的 Langfuse 回调处理程序 来追踪我们应用程序的步骤:config={"callbacks": [langfuse_handler]}

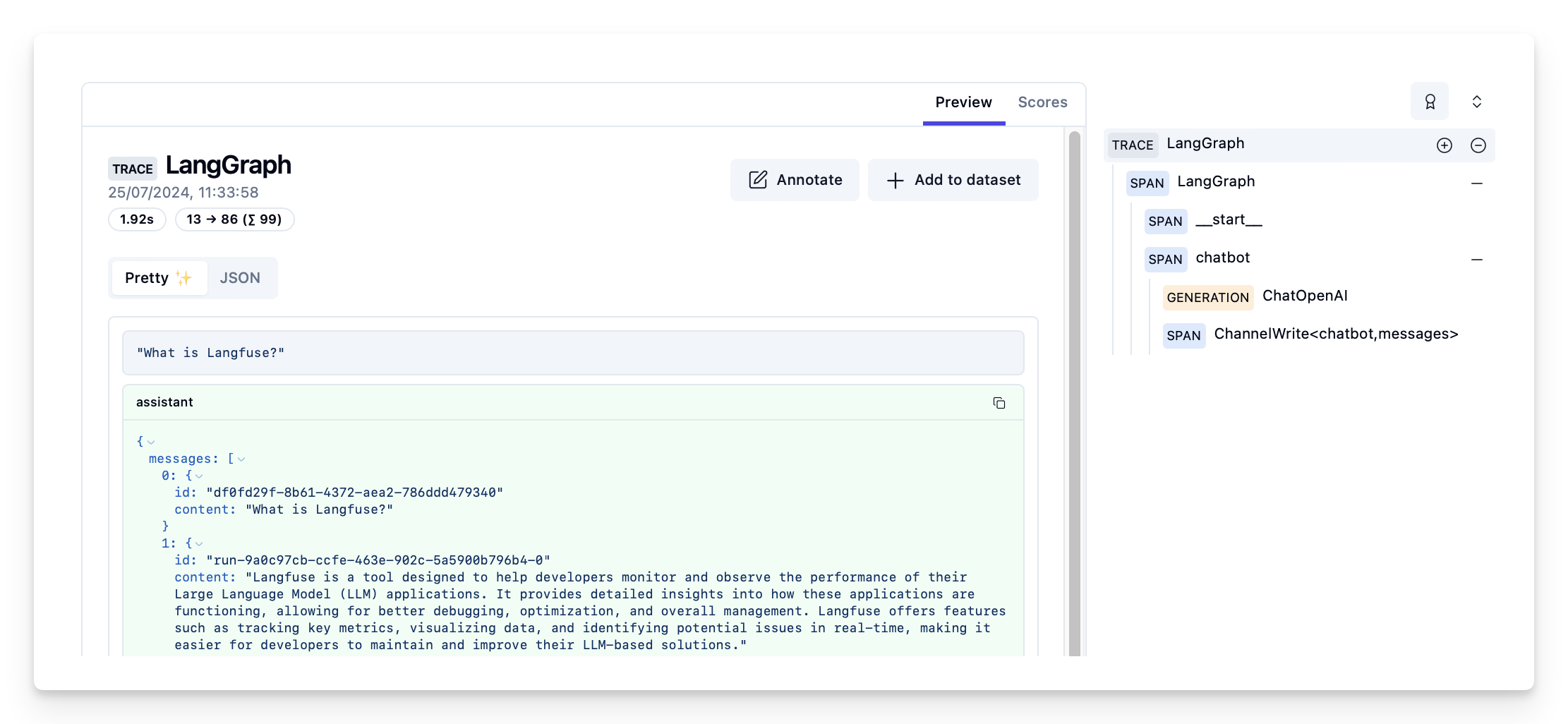

在 Langfuse 中查看追踪

Langfuse 中的追踪示例:https://cloud.langfuse.com/project/cloramnkj0002jz088vzn1ja4/traces/d109e148-d188-4d6e-823f-aac0864afbab

- 查看完整的笔记本以查看更多示例。

- 要了解如何评估 LangGraph 应用程序的性能,请查看LangGraph 评估指南。

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。