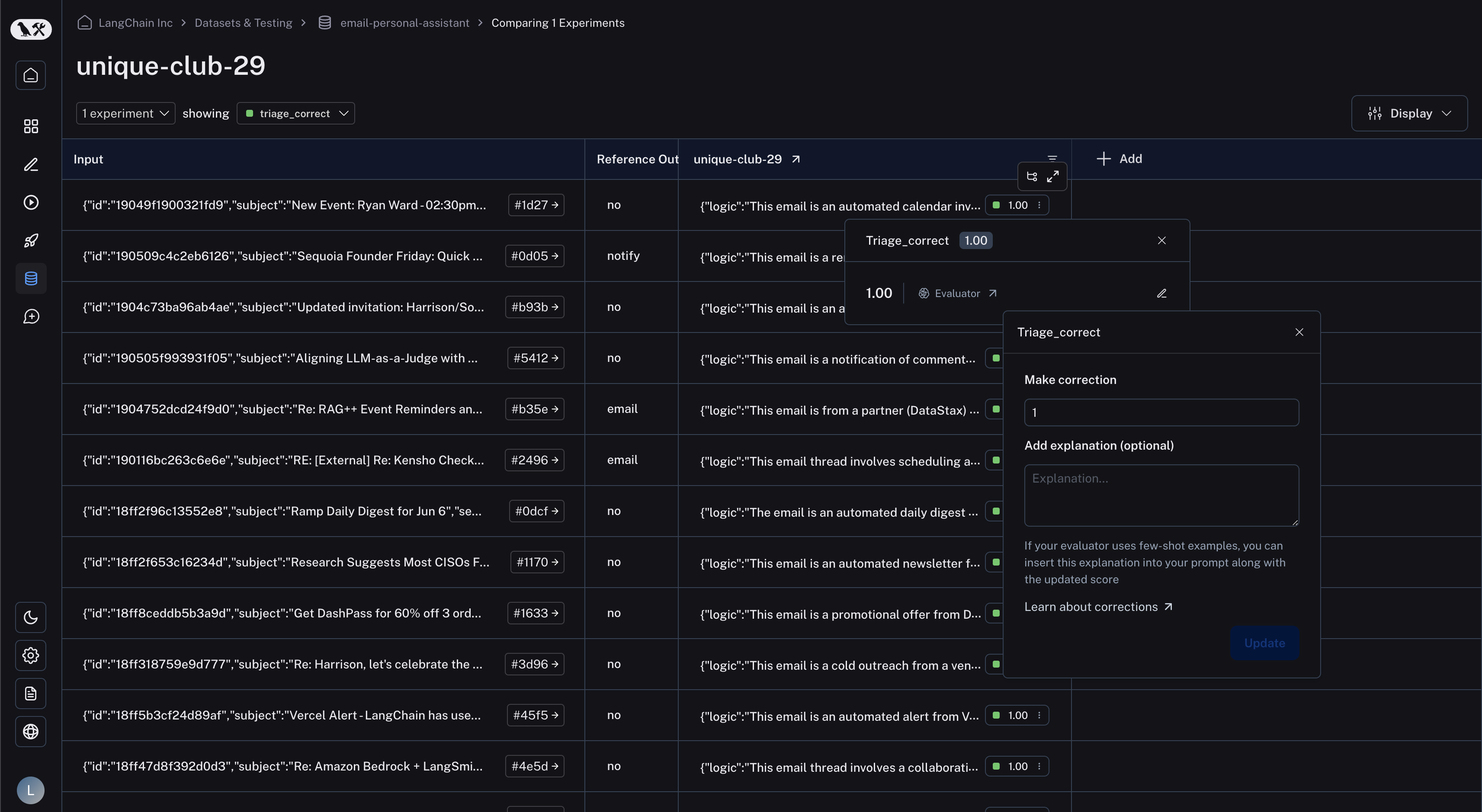

在比较视图中

在比较视图中,您可以点击任何反馈标签以调出反馈详细信息。从那里,点击右侧的“编辑”图标以调出纠正视图。然后,您可以在“进行纠正”下的文本框中输入您想要的分数。如果您愿意,您还可以为您的纠正附上解释。如果您使用的是少样本评估器,这会很有用,并且会自动插入到您的少样本示例中,替换few_shot_explanation提示变量。

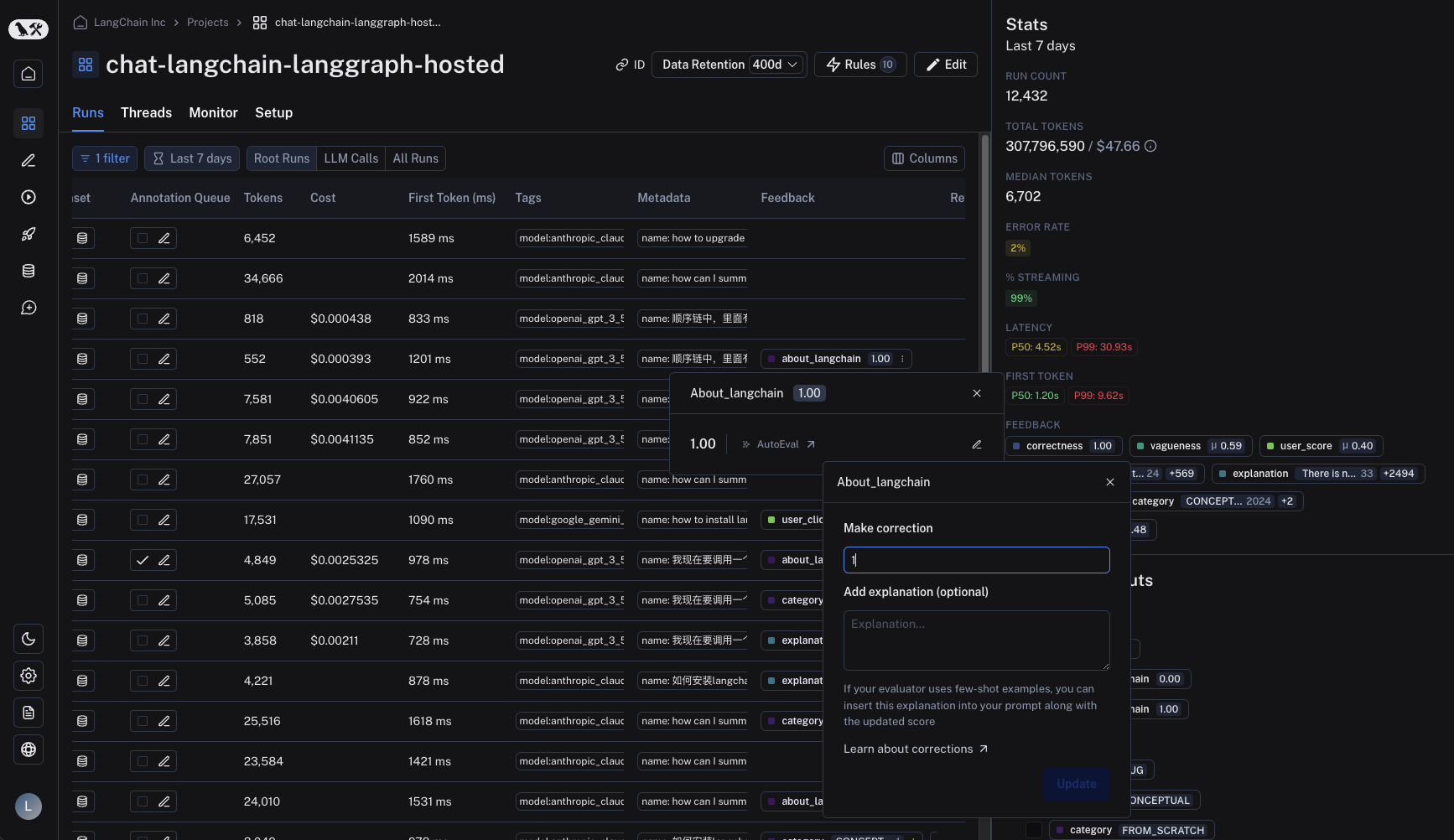

在运行表中

在运行表中,找到“反馈”列并点击反馈标签以调出反馈详细信息。同样,点击右侧的“编辑”图标以调出纠正视图。

在 SDK 中

可以通过 SDK 的update_feedback 函数并带有 correction 字典进行纠正。您必须指定一个 score 键,它对应一个数字,以便在 UI 中渲染。

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。