如果您更喜欢观看有关追踪入门的视频,请参阅数据集和评估视频指南。

先决条件

在开始之前,请确保您拥有- 一个 LangSmith 帐户:在 smith.langchain.com 注册或登录。

- 一个 LangSmith API 密钥:按照创建 API 密钥指南操作。

- 一个 OpenAI API 密钥:从 OpenAI 控制台生成。

- UI

- SDK

1. 设置工作区密钥

在 LangSmith UI 中,确保您的 OpenAI API 密钥已设置为工作区密钥。- 导航至 设置,然后转到密钥选项卡。

- 选择添加密钥并输入

OPENAI_API_KEY和您的 API 密钥作为值。 - 选择保存密钥。

在 LangSmith UI 中添加工作区密钥时,请确保密钥与您的模型提供商预期的环境变量名称匹配。

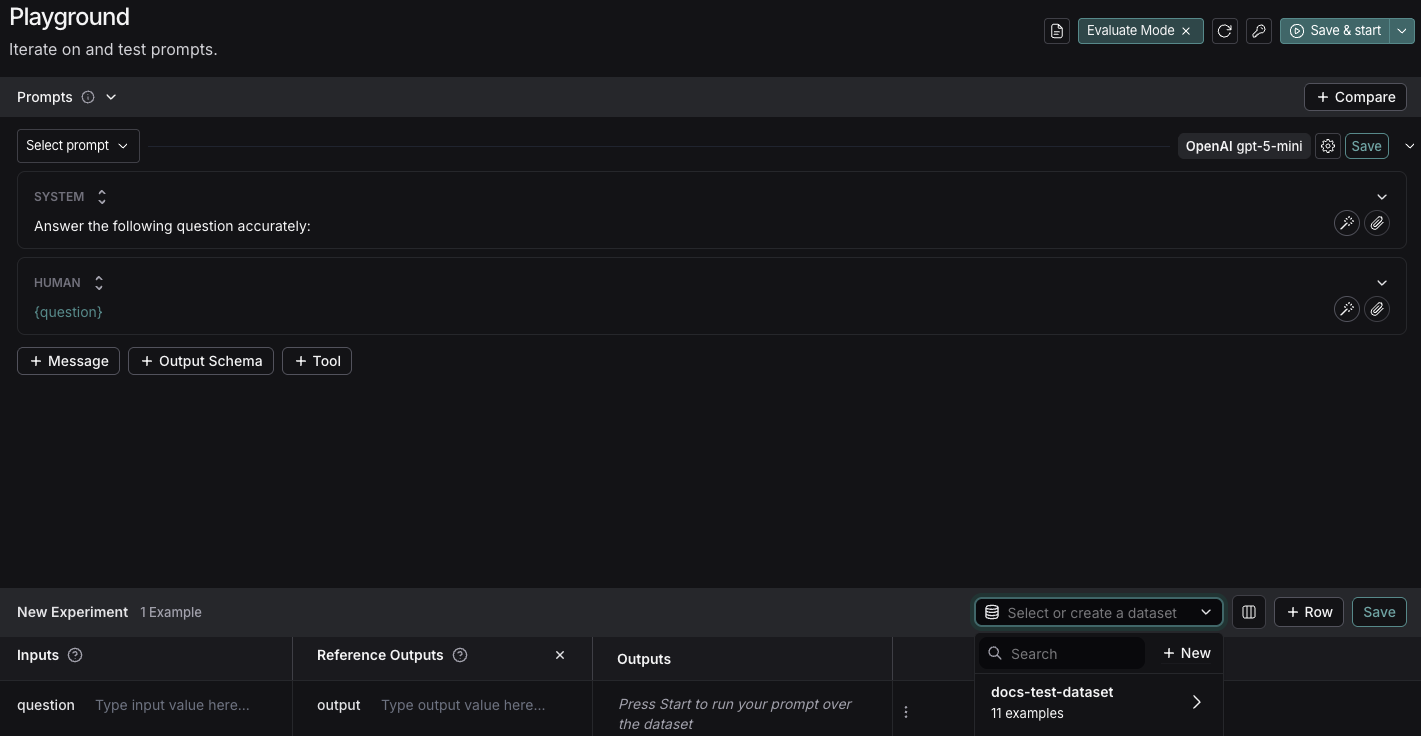

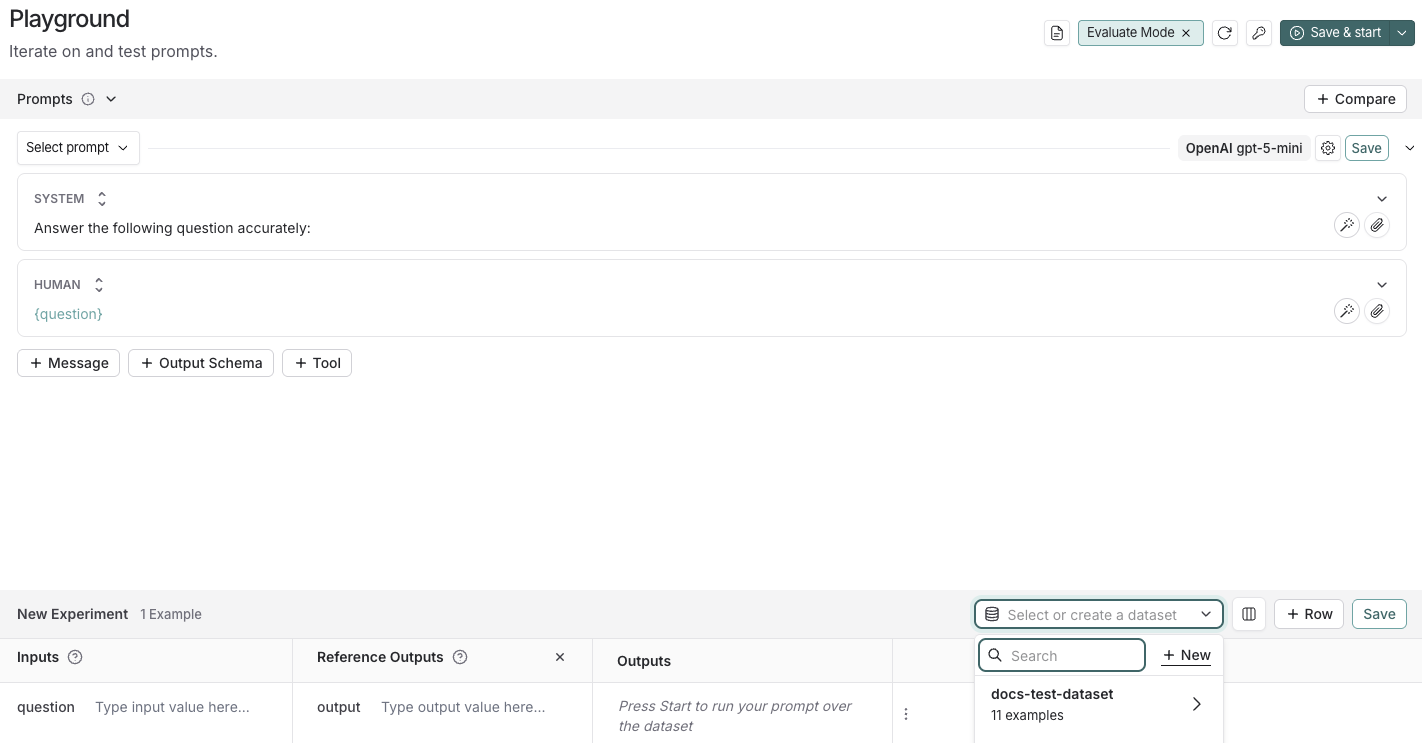

2. 创建一个提示

LangSmith 的提示实验平台使您能够对不同的提示、新模型或测试不同的模型配置进行评估。- 在 LangSmith UI 中,导航到提示工程下的实验平台。

-

在提示面板下,修改系统提示为

保持人类消息不变:

{question}。

3. 创建数据集

- 点击设置评估,这将打开页面底部的一个新实验表。

-

在选择或创建新数据集下拉菜单中,点击+ 新建按钮以创建新数据集。

-

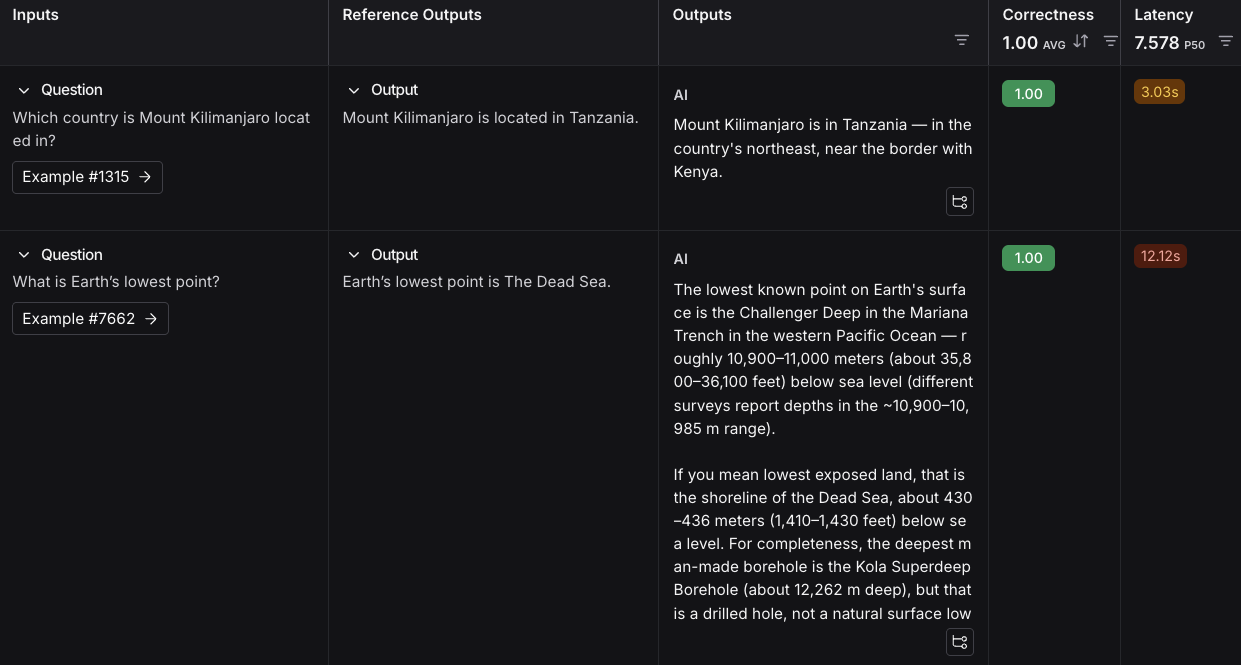

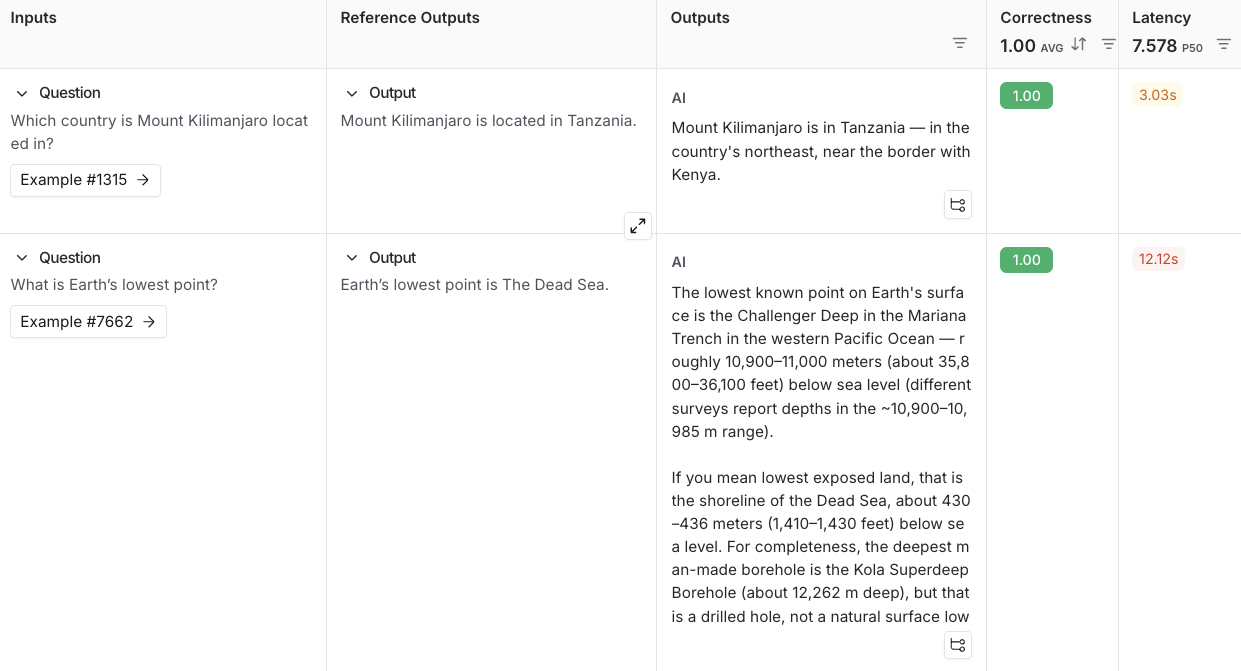

将以下示例添加到数据集中

输入 参考输出 问题:乞力马扎罗山位于哪个国家? 输出:乞力马扎罗山位于坦桑尼亚。 问题:地球的最低点是哪里? 输出:地球的最低点是死海。 - 点击保存并输入名称以保存您新创建的数据集。

4. 添加评估器

- 点击+ 评估器,并从预构建评估器选项中选择正确性。

- 在正确性面板中,点击保存。

5. 运行您的评估

-

选择 右上角的开始以运行您的评估。这将创建一个实验,并在新实验表中提供预览。您可以通过点击实验名称查看完整内容。

后续步骤

要了解更多关于在 LangSmith 中运行实验的信息,请阅读评估概念指南。

- 有关评估的更多详细信息,请参阅评估文档。

- 了解如何在 UI 中创建和管理数据集。

- 了解如何从提示实验平台运行评估。

视频指南

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。