- 配置您的环境。

- 创建一个检索上下文并调用 LLM 的应用程序。

- 启用追踪以捕获检索步骤和 LLM 调用。

- 在 LangSmith UI 中查看结果追踪。

如果您更喜欢观看有关追踪入门的视频,请参阅快速入门视频指南。

先决条件

在开始之前,请确保您拥有- 一个 LangSmith 帐户:在 smith.langchain.com 注册或登录。

- 一个 LangSmith API 密钥:按照创建 API 密钥指南操作。

- 一个 OpenAI API 密钥:从 OpenAI 控制台生成。

1. 创建目录并安装依赖

在您的终端中,为您的项目创建一个目录并在您的环境中安装依赖项2. 设置环境变量

设置以下环境变量LANGSMITH_TRACINGLANGSMITH_API_KEYOPENAI_API_KEY(或您的 LLM 提供商的 API 密钥)- (可选)

LANGSMITH_WORKSPACE_ID:如果您的 LangSmith API 链接到多个工作区,请设置此变量以指定要使用的工作区。

3. 定义您的应用程序

您可以使用此步骤中概述的示例应用程序代码来检测 RAG 应用程序。或者,您可以使用包含 LLM 调用的自己的应用程序代码。 这是一个最小的 RAG 应用程序,直接使用 OpenAI SDK,尚未添加任何 LangSmith 追踪。它有三个主要部分:- 检索器函数:模拟始终返回相同字符串的文档检索。

- OpenAI 客户端:实例化一个纯 OpenAI 客户端以发送聊天完成请求。

- RAG 函数:将检索到的文档与用户问题结合起来形成系统提示,使用

gpt-4o-mini调用chat.completions.create()端点,并返回助手的响应。

app.py 或 app.ts)

4. 追踪 LLM 调用

首先,您将追踪所有 OpenAI 调用。LangSmith 提供了包装器- Python:

wrap_openai - TypeScript:

wrapOpenAI

-

在您的应用程序文件中包含突出显示的行

-

调用您的应用程序

您将收到以下输出

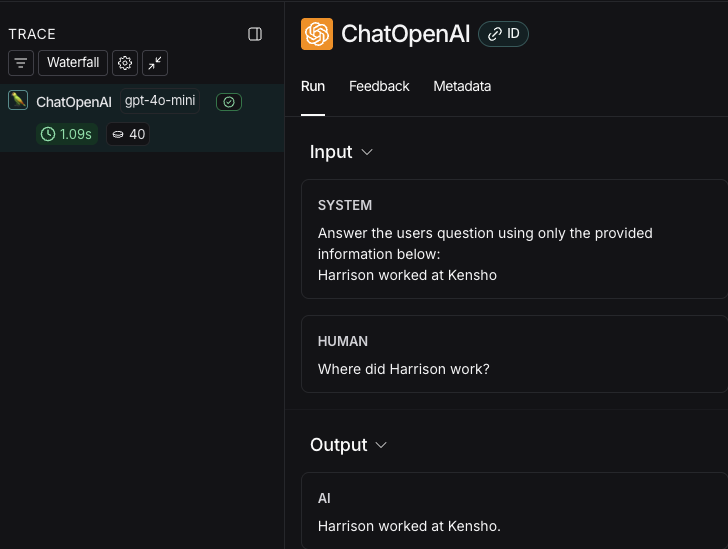

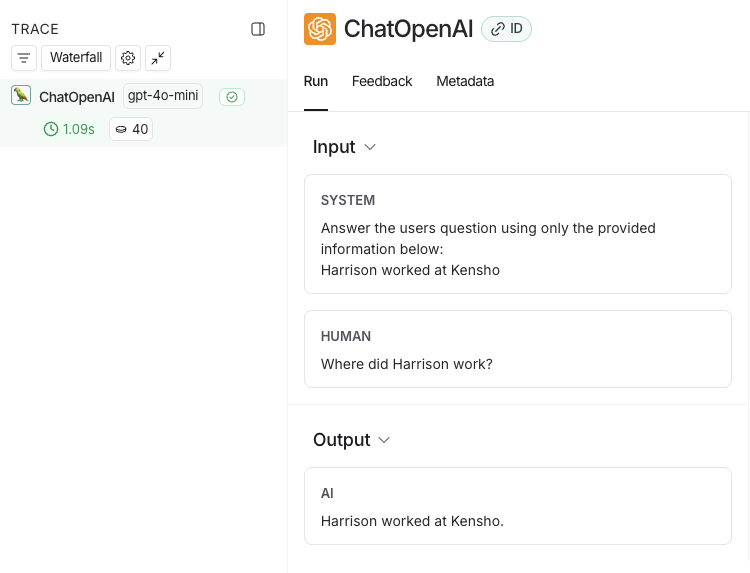

- 在LangSmith UI中,导航到工作区的默认追踪项目(或您在步骤 2 中指定的工作区)。您将看到刚刚检测到的 OpenAI 调用。

5. 追踪整个应用程序

您还可以使用适用于Python 或TypeScript 的traceable 装饰器来追踪整个应用程序,而不仅仅是 LLM 调用。

-

在您的应用程序文件中包含突出显示的代码

-

再次调用应用程序以创建运行

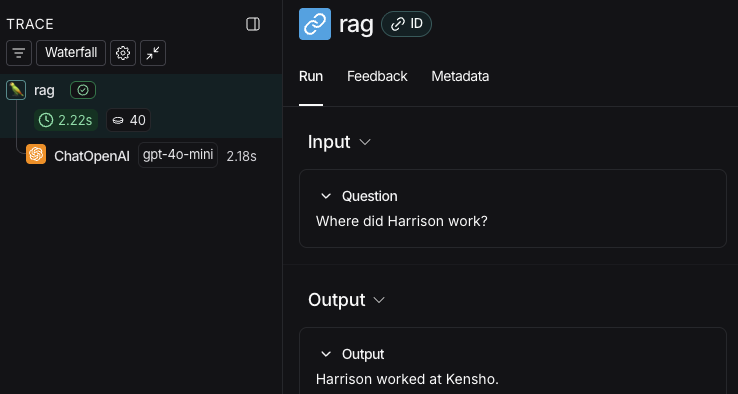

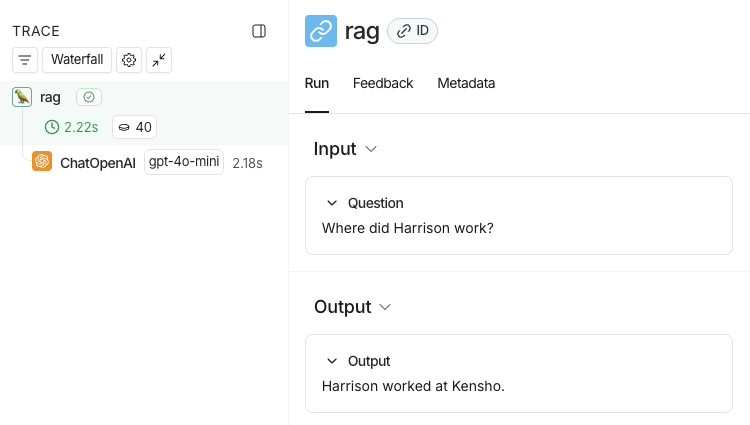

- 返回到LangSmith UI,导航到工作区的默认追踪项目(或您在步骤 2 中指定的工作区)。您将找到包含 rag 步骤和 ChatOpenAI LLM 调用的整个应用程序管道的追踪。

后续步骤

以下是您可能希望接下来探索的一些主题- 追踪集成为各种 LLM 提供商和代理框架提供支持。

- 过滤追踪可以帮助您有效导航和分析包含大量数据的追踪项目中的数据。

- 追踪 RAG 应用程序是一个完整的教程,它将可观测性添加到从开发到生产的应用程序中。

- 将追踪发送到特定项目会更改追踪的目标项目。

视频指南

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。