使用 LangChain

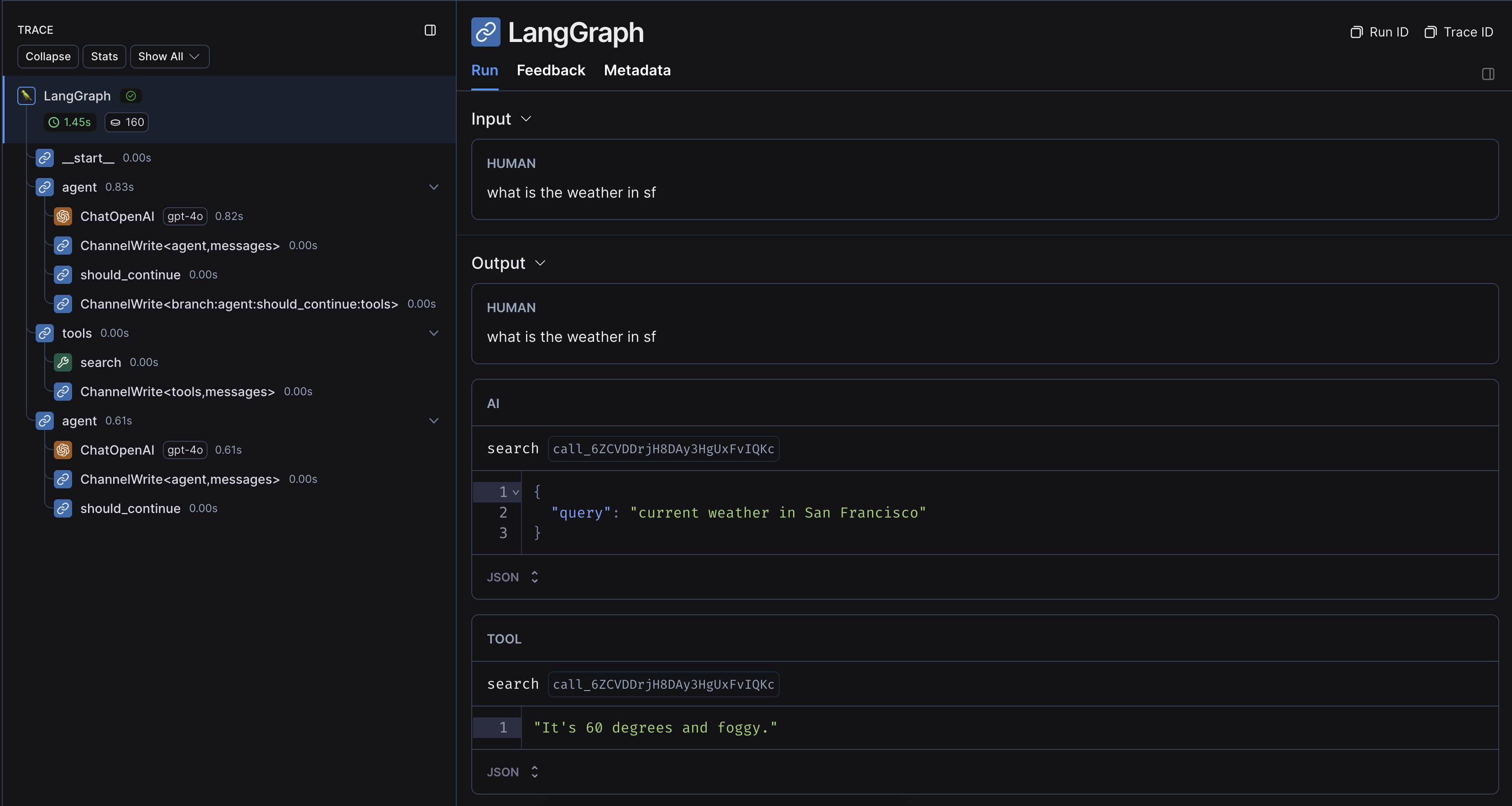

如果您在 LangGraph 中使用 LangChain 模块,您只需设置几个环境变量即可启用追踪。 本指南将通过一个基本示例进行介绍。有关配置的更详细信息,请参阅使用 LangChain 追踪指南。1. 安装

为 Python 和 JS 安装 LangGraph 库和 OpenAI 集成(我们将在下面的代码片段中使用 OpenAI 集成)。 有关可用包的完整列表,请参阅 LangChain Python 文档和LangChain JS 文档。2. 配置您的环境

如果您将 LangChain.js 与 LangSmith 配合使用,并且不在无服务器环境中,我们还建议明确设置以下内容以减少延迟:

export LANGCHAIN_CALLBACKS_BACKGROUND=true如果您在无服务器环境中,我们建议设置相反的值,以允许追踪在函数结束前完成:export LANGCHAIN_CALLBACKS_BACKGROUND=false有关更多信息,请参阅此 LangChain.js 指南。3. 记录追踪

设置好环境后,您可以正常调用 LangChain 可运行项。LangSmith 将推断出正确的追踪配置。

不使用 LangChain

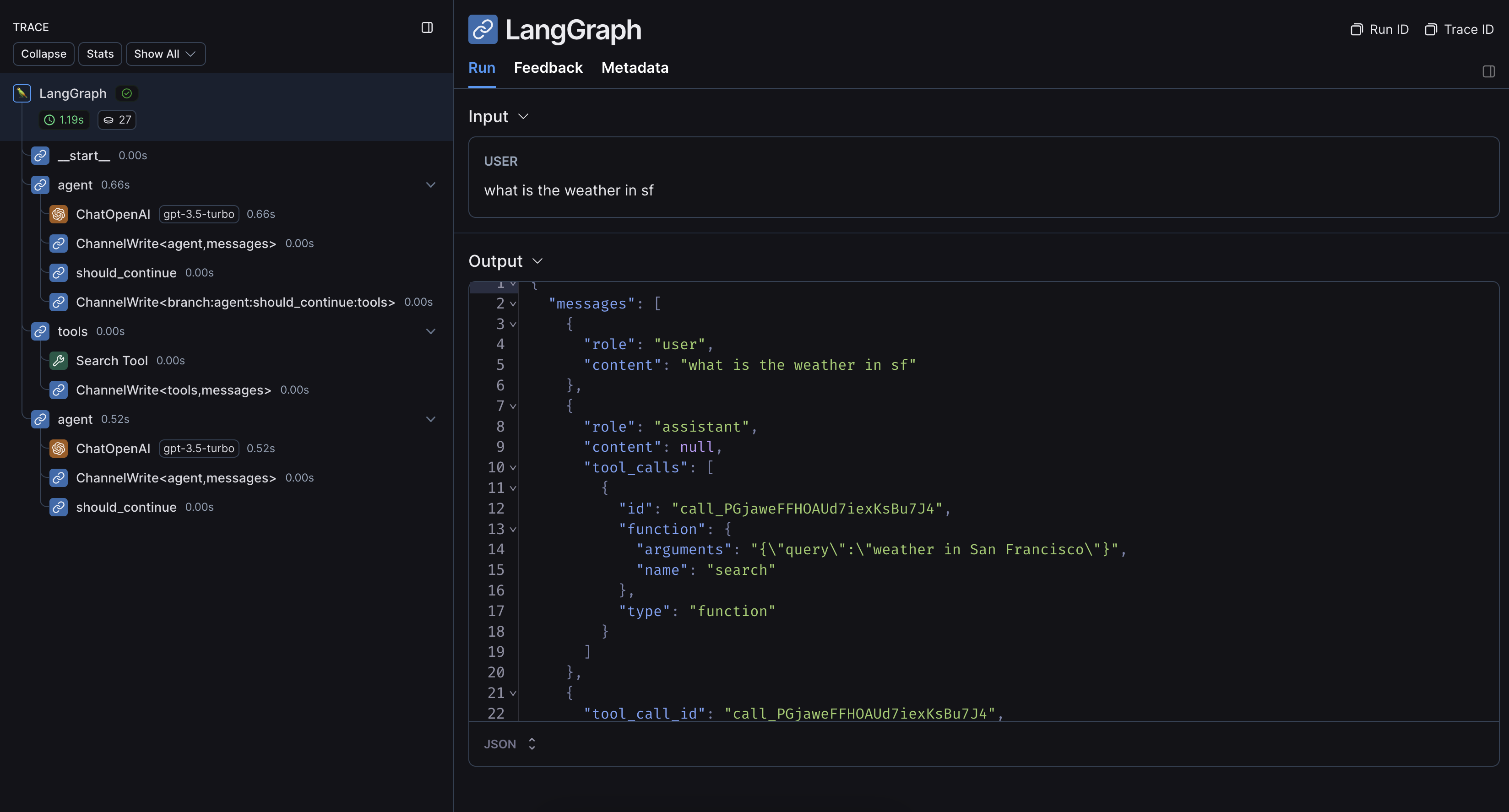

如果您在 LangGraph 中使用其他 SDK 或自定义函数,您需要适当地包装或修饰它们(Python 中使用@traceable 装饰器,JS 中使用 traceable 函数,或者例如针对 SDK 使用 wrap_openai)。如果这样做,LangSmith 将自动嵌套来自这些包装方法的追踪。 这是一个示例。您还可以查看此页面以获取更多信息。1. 安装

为 Python 和 JS 安装 LangGraph 库和 OpenAI SDK(我们将在下面的代码片段中使用 OpenAI 集成)。2. 配置您的环境

如果您将 LangChain.js 与 LangSmith 配合使用,并且不在无服务器环境中,我们还建议明确设置以下内容以减少延迟:

export LANGCHAIN_CALLBACKS_BACKGROUND=true如果您在无服务器环境中,我们建议设置相反的值,以允许追踪在函数结束前完成:export LANGCHAIN_CALLBACKS_BACKGROUND=false有关更多信息,请参阅此 LangChain.js 指南。3. 记录追踪

设置好环境后,包装或修饰您要追踪的自定义函数/SDK。LangSmith 将推断出正确的追踪配置。

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。