在实验中配置重复

将可选的num_repetitions 参数添加到 evaluate / aevaluate 函数中(Python, TypeScript),以指定对数据集中每个示例进行评估的次数。例如,如果数据集中有 5 个示例并将 num_repetitions=5,则每个示例将运行 5 次,总共运行 25 次。

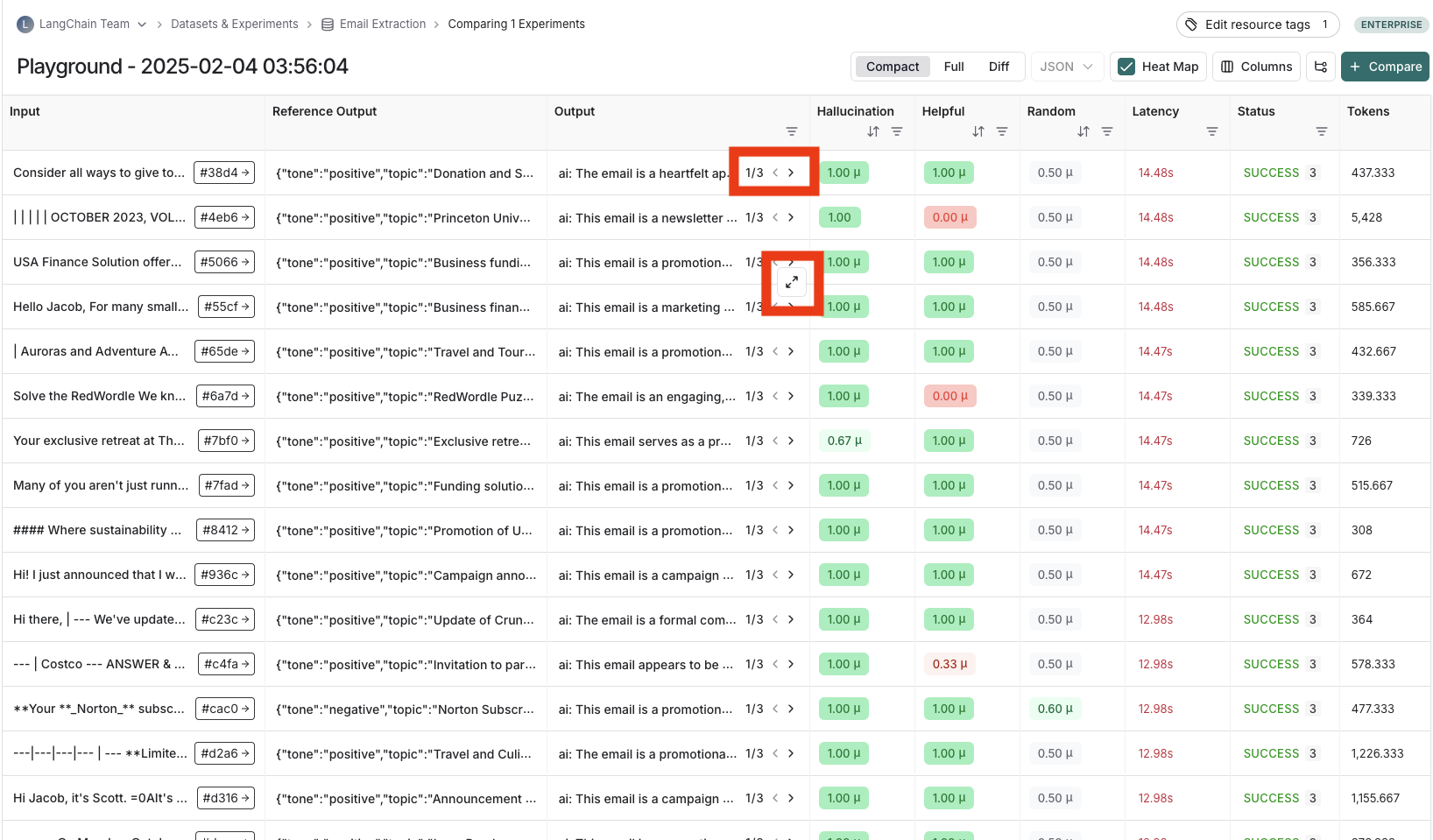

查看重复运行的实验结果

如果您使用重复运行了实验,输出结果列中将有箭头,以便您可以在表格中查看输出。要查看重复中的每次运行,请将鼠标悬停在输出单元格上并单击展开视图。当您重复运行实验时,LangSmith 会在表格中显示每个反馈分数的平均值。单击反馈分数可查看单个运行的反馈分数,或查看重复的标准偏差。

以编程方式连接这些文档到 Claude、VSCode 等,通过 MCP 获取实时答案。